Cliente: GfK Italia

Categoria: Misurazione audience

Descrizione sintetica: software di audio matching ad elevate prestazioni.

Tipo di attività: sviluppo di algoritmi matematici, implementazione software su architetture in cluster distribuito

Briefing cliente

Progettare, costruire e mantenere operativo un sistema capace di individuare, all’interno della programmazione giornaliera dei canali televisivi, la messa in onda degli spot pubblicitari.

Descrizione del prodotto

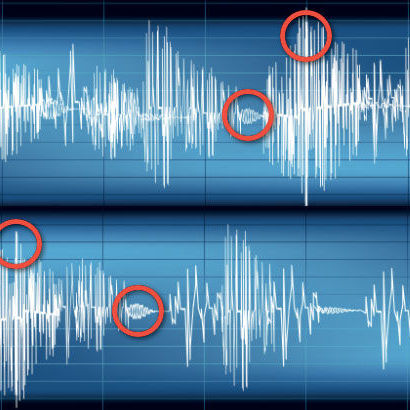

SpotFinder è un prodotto per l’identificazione di campagne pubblicitarie all’interno delle emissioni radio e televisive. Per il suo funzionamento, SpotFinder ha bisogno di costruire una libreria di tutti gli spot pubblicitari che devono essere riconosciuti. La libreria può essere fornita dalle singole agenzie pubblicitarie, dai clienti finali, oppure generata in totale autonomia a partire dalle trasmissioni stesse, grazie al lavoro di operatori specializzati. Per ogni spot pubblicitario viene estratta la traccia audio che viene poi ricercata all’interno dei canali da analizzare (oltre 200 nell’attuale setup). La ricerca avviene ogni giorno ed il risultato dell’analisi è la compilazione automatica di un log di emissione che certifica l’effettiva messa in onda dei singoli spot, i canali interessati e l’ora precisa di messa in onda. L’algoritmo di ricerca e di match è in grado di distinguere tra due spot che differiscano anche di una singola parola e di individuarli correttamente all’interno della programmazione giornaliera. Come immaginabile, la complessità computazionale è elevatissima. Per questo motivo, considerando anche il carattere continuativo dell’analisi, è stato necessario sviluppare l’algoritmo in modo che possa essere eseguito su un cluster di elaborazione parallelo e distribuito, ottimizzandolo in termini di velocità di esecuzione, anche al fine di contenere i costi per l’infrastruttura informatica necessaria.

Specifiche e peculiarità tecnologiche

Sviluppo di algoritmi matematici complessi di analisi audio, ottimizzazione del software per il calcolo parallelo e distribuito, realizzazione di un cluster di elaborazione dati ad alta affidabilità, gestione del cluster, supervisione continua, 24 ore su 24.